唐杰、文继荣领衔:预训练模型 | CNCC2021技术论坛预告

CNCC2021将汇聚国内外顶级专业力量、专家资源,为逾万名参会者呈上一场精彩宏大的专业盛宴。别缺席,等你来,欢迎参会报名!

【预训练模型】技术论坛

【论坛背景介绍】

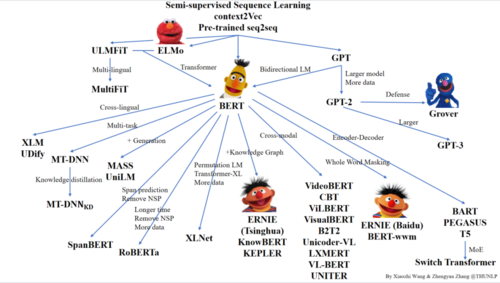

大规模预训练模型通过学习海量互联网无标注数据,获得了强大的文本理解与生成能力。近年来,BERT等预训练模型在自然语言处理等诸多领域取得了极大地进展。随着超大规模预训练模型GPT-3、悟道的发布,预训练模型在自然语言理解以及生成能力上再次被推至新的高峰。

预训练语言模型家族谱

在预训练模型如火如荼的发展背景下,为了帮助研究人员更好地了解预训练模型的相关前沿进展,本次论坛共邀清华大学、中国人民大学等机构的专家学者与国内其他预训练模型研究团队代表共同研讨预训练模型的进展、挑战与机遇。

按报告时间顺序为:清华大学计算机系教授、系副主任唐杰(IEEE Fellow);中国人民大学信息学院院长、高瓴人工智能学院执行院长文继荣教授;清华大学计算机科学与技术系长聘副教授、智能技术与系统实验室副主任黄民烈博士;中国人民大学信息学院计算机系副教授张静;清华大学计算机科学与技术系助理研究员韩文弢;清华大学计算机科学与技术系六年级博士生裘捷中。

论坛主席

论坛日程安排

时间 | 主题 | 主讲嘉宾 | 单位及任职 |

19:00-19:30 | 悟道—超大规模预训练模型 | 唐杰 | 清华大学计算机系教授、系副主任 |

19:30-20:00 | 悟道∙文澜:超大规模多模态预训练改变了什么? | 文继荣 | 中国人民大学信息学院院长、高瓴人工智能学院执行院长 |

20:00-20:30 | 基于大规模预训练模型的开放域对话系统EVA | 黄民烈 | 清华大学计算机科学与技术系长聘副教授 |

20:30-21:00 | 基于预训练语言模型的知识图谱推理研究 | 张静 | 中国人民大学信息学院计算机系副教授 |

21:00-21:30 | 面向预训练模型的全流程高效计算框架探索 | 韩文弢 | 清华大学计算机科学与技术系助理研究员 |

21:30-22:00 | FastMoE:开源大规模分布式 MoE 训练框架

| 裘捷中 | 清华大学计算机科学与技术系六年级博士生 |

讲者介绍

CNCC2021将于10月28-30日在深圳举行,今年大会主题是“计算赋能加速数字化转型”。CNCC是计算领域学术界、产业界、教育界的年度盛会,宏观探讨技术发展趋势,今年预计参会人数将达到万人。每年特邀报告的座上嘉宾汇聚了院士、图灵奖得主、国内外名校学者、名企领军人物、各领域极具影响力的业内专家,豪华的嘉宾阵容凸显着CNCC的顶级行业水准及业内影响力。

今年的特邀嘉宾包括ACM图灵奖获得者John Hopcroft教授和Barbara Liskov教授,南加州大学计算机科学系和空间研究所Yolanda Gil教授,陈维江、冯登国、郭光灿、孙凝晖、王怀民等多位院士,及众多深具业内影响力的专家。今年的技术论坛多达111个,无论从数量、质量还是覆盖,都开创了历史之最,将为参会者带来学术、技术、产业、教育、科普等方面的全方位体验。大会期间还将首次举办“会员之夜”大型主题狂欢活动,让参会者畅快交流。

CNCC2021将汇聚国内外顶级专业力量、专家资源,为逾万名参会者呈上一场精彩宏大的专业盛宴。别缺席,等你来,欢迎参会报名!

CNCC2021参会报名

返回首页

返回首页