CCF广东工业大学学生分会举办“人工智能中关联、因果与影响、无限维理解下的深度学习理论与算法”学术报告

广东工业大学CCF学生分会于2024年1月12日(星期五)15:30成功举办了主题为“人工智能中的关联、因果与影响”和“无限维理解下的深度学习理论与算法”的学术讲座。本次学术讲座有两场精彩的报告,分别由周志华教授和孟德宇教授为我们带来,报告由蔡瑞初老师主持。

周志华教授,南京大学计算机系主任兼人工智能学院院长,CCF会士,校学术委员会委员,国家基金委创新群体负责人,国际人工智能联合会理事会主席,欧洲科学院外籍院士,ACM、AAAI、IEEE等的Fellow。在人工智能与机器学习领域取得了在国际上有重要影响的原创引领性成果,著有《机器学习》《集成学习:基础与算法》等中英文著作四部,多项发明技术在我国重点企业转化实施取得显著成效,并在某重大任务中领衔攻关取得重大成果。第一完成人成果获国家自然科学二等奖两项、教育部自然科学一等奖三项,以及国家级教学成果一等奖,并获得IEEE计算机学会Edward J. McCluskey技术成就奖、CCF王选奖、首届CCF-ACM人工智能奖、亚洲机器学习卓越贡献奖等。

周志华教授的报告主题是《人工智能中的关联、因果与影响》,周志华教授首先介绍了当前人工智能的一个挑战,即我们的模型可以很好的预测“不希望发生的事件”,但是我们该如何来避免“不希望事件”的发生呢?当前人工智能模型的决策能力还不够,而周志华教授提出了“影响关系”这一新颖概念,希望以后的AI模型的发展具备识别这一关系的能力,从而提升模型的决策能力。周志华教授指出,当前人工智能模型主要利用“相关性”和“因果性”两种关系来做预测等任务,但是对于“相关性”来说,它对预测任务是有帮助的,但是它不能知道我们应该做什么来避免“不希望事件”,而对于“因果性”来说,它可行但并不必要。随后,周志华教授给出了如下原因解释了为什么因果性不必要:(1)做决策不需要对因果关系有详尽的理解,就好比我们每天都在做决策,但我们对周围的世界并没有完整的认知。(2)真实环境是开放动态的,而因果关系可能随环境变化。(3)即便识别出一些因果变量,它们可能也是不可操作的。(4)做决策不需要依赖对因果关系的正确认知。(5)因果关系的建模存在不适当,现实中两者可能是相互影响的,但因果建模是不能互为因果的。针对以上等问题,周志华教授提出了Influence(影响性)和Rehearsal(排演)的概念。

周志华教授指出关联,因果,影响这三者的关系是:(1)因果关系和影响都是关联关系的子集。(2)影响关系包含了一部分变量可操作的因果关系和一部分非因果关系。紧接着,周志华教授为我们介绍了Rehearsal framework(排演框架),它的核心要义是做出某种Rehearsal operation(排演操作)后使得我们“不希望事件”发生的概率要小于不发生的概率,这一决策过程应该尽可能包含少的变量并且我们不需要估算具体的概率值。总体来说,Rehearsal framework(排演框架)包含4个步骤:(1)构造排演图。(2)在可操作变量上进行排演操作。(3)估计排演后对未来的影响,包括学习目标变量Y在历史数据中如何被其他变量影响,在短期和长期内估计其他变量排演后的影响。(4)评价排演操作的影响。

周志华教授的报告精彩无比,经过老师、同学们和周志华教授的热烈讨论一番后,接着由孟德宇教授为我们带来主题为《无限维理解下的深度学习理论与算法》的报告。

孟德宇,西安交通大学教授,博导,CCF杰出会员,长江学者特聘教授,大数据算法与分析技术国家工程实验室统计与大数据中心副主任。发表论文百余篇,其中IEEE汇刊论文60余篇,计算机学会A类会议40余篇,谷歌学术引用超过26000次。任IEEE Trans. PAMI,National Science Review等7个国内外期刊编委。主要研究方向为机器学习、计算机视觉领域的基础研究问题。

孟德宇教授指出现有深度学习方法大多通过有限维的方式来对数据表示、网络架构等基本元素进行设计,然而,这些元素真正的内在表达却应为无限维。采用简化的有限维设计往往忽略算法各元素的本质无限维内涵,从而带来算法理论探索及应用扩展的局限。针对这一问题,本报告将尝试针对图像无限维表达、卷积核无限维表达、梯度场无限维表达等问题展开讨论,分别介绍研究团队在参数化卷积核,无限维神经表达,深度网络的类量子不确定性原理等深度学习基础理论与算法方面所作出的初步探索成果,并介绍基于其所延伸出一些典型示例应用。

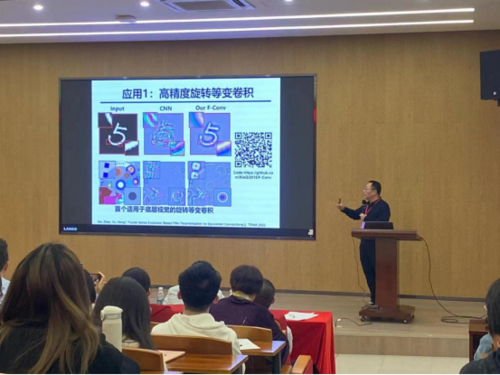

首先,孟德宇教授表示当前深度学习中的卷积算子在数学层面上已被证明了具备平移不变性,但传统的卷积核仍然存在不具备旋转不变性和尺度不变性的缺陷,针对离散卷积不能够很好进行不变性变化操作的局限性。孟德宇教授沿用了连续卷积核表示的思路,对参数化的卷积进行了相应的研究。现有的参数化卷积核的构造一般通过将待参数化的卷积核表示为一系列特定函数基底的线性组合,但目前此方法精度不高,在各方面领域应用很少,仍然有很多值得挖掘和探讨的地方。因此孟德宇教授提出了一种基于傅里叶基底的高精度参数化卷积核,这种形式的卷积核可以对任意一个离散卷积核完美地进行零误差的表示,并且针对傅里叶基底在函数变换时候产生的混叠效益,孟德宇教授采用镜像的方式巧妙地解决了这一问题。随后,孟德宇教授讲解了高精度旋转等变卷积在手写数字识别、角度共享卷积利用平移不变性减少医疗图像中伪影和尺度等变卷积在视网膜图像分割的应用。

紧接着,孟德宇教授为我们介绍了报告第二个要点,深度网络的高精度与易攻击制衡。研究表明,高精度分类器容易被梯度算法攻击,使其分类精度大幅下降,大量的实验也展示了高精度和易攻击之间存在某种制衡。孟德宇教授表示模型越是想要把个体样本的分类精度提高,模型的鲁棒性就越差,越容易被梯度算法攻击,因此,需要对个体和整体进行深入剖析,从更本质的层面理解问题。为此,孟德宇教授介绍了著名的量子力学不确定性原理,神经网络的不确定性原理就是基于此而产生的,因此两者之间可以照着同一模板进行理解。

报告的最后,孟德宇教授发表了自己多年研究的感想。孟德宇教授认为数学领域和机器学习领域研究的问题存在非常多相似和值得相互借鉴的地方,对于同一个问题,机器学习领域的定义是离散的,而数学领域的定义是连续的,尽管两个领域的术语不同,但是两者研究问题的思路非常值得相互借鉴与学习。例如,变分推断算法在机器学习领域已经被提出近30年,但一直局限于有限维空间,但其实变分推断完全可以应用与无限维。因此,孟德宇教授鼓励两个领域的学者们要相互多交流,一起探讨问题,去共同创造无限可能的未来。

十分感谢周志华教授和孟德宇教授为我们带来精彩报告,对于本次精彩绝伦的学术讲座,现场老师同学们的反响非常积极与热烈,与两位教授进行了很多方面的探讨,极大地促进和提升了同学们的科研热情,为老师同学们带来了很多新颖的创新思路。未来我们将继续举办更多的精彩讲座,促进学术交流和提升学术氛围,为广大师生们提供更多学术资源和良好交流平台。

返回首页

返回首页