最近,来自加州大学伯克利分校的RICHARD ZHANG、JUN-YAN ZHU、PHILLIP ISOLA等人写了一篇题为“用Learned Deep Priors来实时指导图像着色”的论文,这篇文章提出了一种有趣的图像着色方案。

以下是论文的主要内容:

摘要

我们提出了一种有趣的深度学习方法,来实时指导用户进行图像着色。该网络会结合输入的灰度图像和简单的用户提示,直接映射到卷积神经网络(CNN),即可输出用户满意的彩色图。

传统的神经网络一般通过人为地定义相关规则,并从大规模数据集中学习高级语义信息,融合图像的低级特征,来帮助用户对图像进行着色。我们通过模拟用户操作,训练了一百万张图像。

为了引导用户选择有效的着色方案,该系统会根据输入图像和当前用户的输入来提出最佳的着色方案。图像着色仅通过单次前向传播即可完成,计算量小,可实时完成。

我们随机地模仿用户进行输入,从视频中可以看出,该系统可帮助新手快速地创建逼真的图像,且在简单熟悉后,新手们在着色质量上大幅改善。

此外,我们还表明,该框架可以应用颜色直方图转换的功能,将其他用户的“提示”纳入备选的着色方案中。

示例视频

在传统照片上的效果

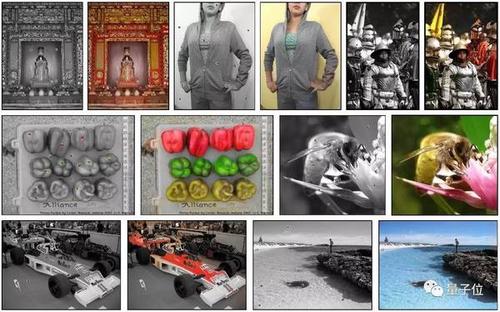

我们使用130万张彩色照片来训练这个图像着色系统,通过去除RGB分量来合成灰度图。在这里,我们展示一些示例。

其他结果

下面我们展示出一些用户的操作效果。每个用户在每张图像上大约花费了1分钟。对于参加实验的28个用户,我们进行了简短的2分钟解释和说明了相关要点,并给出了10张图像进行着色测试。我们给出了28个用户对这10张图像的着色方案。你可以从论文的第4.2节查到该部分的相关信息和延伸。

我们还展示了包含有全局直方图信息的扩展性网络,请参阅论文的第3.3节和第4.4节。下图是应用随机直方图的转化效果。

网络架构

相关地址

Paper:

https://arxiv.org/pdf/1705.02999.pdf

对Paper的补充材料:

https://richzhang.github.io/ideepcolor/

Code:

https://github.com/junyanz/interactive-deep-colorization