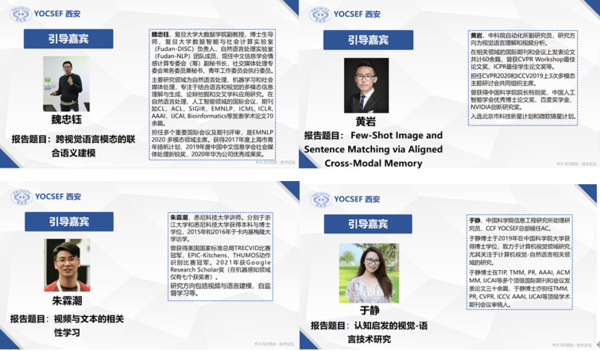

CCF YOCSEF西安于2021年4月24日下午14:00成功举办了“计算机视觉与自然语言处理如何1+1>2?”的技术论坛活动。论坛邀请到复旦大学大数据学院魏忠钰副教授、中科院自动化所黄岩副研究员、悉尼科技大学朱霖潮博士和中国科学院信息工程研究所于静助理研究员4位引导发言嘉宾。

YOCSEF西安主席王鹏和YOCSEF西安AC委员马苗为本次论坛的执行主席,YOCSEF西安AC委员王小凤和YOCSEF西安委员裴炤担任本次论坛的线上主席。论坛采用线上、线下、微论坛同步进行的方式,近300余人参加了本次论坛。

跨媒体智能是人工智能重要研究方向之一,也是我国人工智能战略规划的重要组成部分。而计算机视觉与自然语言处理相结合的人工智能研究则是跨媒体智能中关键的一个子领域。近年来,视觉+语言的研究得到长足的发展,新奇而有趣的任务层出不穷,算法模型性能不断提高。然而,在一些典型的视觉+语言任务上,似乎也出现了一些瓶颈。在未来5-10年,视觉+语言的发展趋势和研究重点应该在哪里?应该注意什么问题?是本论坛所关心的话题。

本次论坛主要分为技术报告、思辨环节和互动提问三部分。

一、技术报告

YOCSEF西安AC委员马苗作为技术报告主持人,对本次论坛背景及特邀演讲嘉宾做了介绍。

魏忠钰发言题目为:跨视觉语言模态的联合语义建模。他认为,视觉和语言是我们感知和理解外部环境的重要方式,某种程度上说,它们是同一个客观世界的两套表示方法,并且互有侧重。如何在建模时捕捉二者的交互关系和共同的语义表达式一个非常值得研究的课题。魏博士同时介绍了在跨模态语义联合建模方面的一些探索工作。

黄岩发言题目为:Few-Shot Image and Sentence Matching via Aligned Cross-Modal Memory。他认为,计算机视觉与自然语言处理交叉学科的一个基础问题是图像与语言的对齐。他认为其中的核心难点在于其中的小样本问题:训练集不常见的图像或词语很难通过现有数据驱动的方法进行匹配,并介绍了自己在小样本跨模态匹配方向的工作。

朱霖潮发言题目为:视频与文本的相关性学习。在发言中,朱博士讨论了多模态建模中几种可行的研究模型,以及这些模型在视频与语言的任务上的创新点。

于静发言题目为:认知启发的视觉-语言技术研究。她认为,目前解决视觉-语言问题的主流深度学习方法主要依靠观察大量数据“归纳”出输入与输出的关联关系,但是解决这些问题的本质在于让机器真正具有人的“认知”能力。于博士基于现有的认知框架,结合近期的几个工作,阐述了如何通过改变表征方式、模型架构、任务目标等方法,来探索认知机理启发的视觉-语言技术及挑战。

论坛分别为四位嘉宾颁发了感谢牌。

二、思辨环节

思辨环节由执行主席王鹏主持,内容包括三个论点,四位嘉宾、主持人王鹏和线上线下参与者针对这些论点进行了积极的发言和热烈的辩论,得出一系列不同角度的新颖观点。

话题1:Transformer在CV和NLP领域各种屠榜,未来能否成为跨模态大一统模型?

一方面,Transformer模型较弱的归纳偏置导致其具有较强的适用性和泛化性,确实在计算机视觉、自然语言处理等多个领域具有成为大一统模型的潜力。并且工业界拥有更大的数据和算力资源,未来有望更多的采用Transformer模型来处理不同模态的数据。但另一方面,不同的具体问题仍然具有各自的特性,Transformer可以作为一个很好的基础网络,但是在特定任务上,仍然需要进行调整才能发挥最大效果,而且Transformer的可解释性问题也仍然是一个开放性的问题。同时,Transformer与其他模型设计思路的结合也是一个具有前景的方向。

话题2:CV和NLP领域下一个结合点在哪里?

关于为何CV和NLP领域的结合会成为一个研究热点,与会者有不同角度的见解。一方面,计算机视觉中诸如分类、检测等基础性的任务得到较好解决后,更高层次的语义级视觉任务成为新目标,这也促使CV研究与语义级别的NLP研究进一步紧密结合。另一方面,语言、视觉某种程度上都用于描述客观世界,是只是表述形式不同,两者本身就存在相当密切的关联,这也是激发CV和NLP领域交叉的根本性原因之一。

未来CV和NLP领域的结合点则可从工业界和学术界两个角度来讨论。在工业界,随着短视频应用的兴起,相关的面向视频的跨模态检索交互具有广阔的应用前景。同时以人为中心的智能交互应用,也是未来非常值得关注的领域。在学术界,则应关注各种视觉-语言任务的共性基础问题,例如推理、因果关系、可解释性、小样本问题等。

3.从“大训模型”到“训大模型”,如何做低碳的视觉+语言研究?

这个问题得到了来到现场的老师和同学们的热切关注。通过在超大数据上训练超大模型,确实在“提点”方面有明显效果。但是,科研的最终目标并不是“题点”,而是提出问题、发现问题和解决问题。从这个角度看,不是所有的科研都需要依赖“大模型”。此外,视觉—语言交叉研究是一个相对更加开放和包容的领域,发表论文或成果并不一定非要基于“大模型预训练”,这也为数据和计算资源不那么丰富的研究者提供了更多的机会。与会着还探讨了很多节省计算资源的模型训练技巧,诸如layer-wise training,从预训练模型直接提取特征等,也为在场的老师学生提供了更具体的思路。

线上主席YOCSEF西安AC委员王小凤和候补委员裴炤分别用文字和图片主持,同步论坛内容。论坛在热烈的氛围中圆满结束。会后部分参加人员进行了合影。

所有评论仅代表网友意见