大规模预训练模型是否是通向通用人工智能的可行方向?

2018年,大规模预训练技术极大提高了深度神经网络对大规模无标注数据的自监督学习能力,在GPU多机多卡算力和海量无标注文本数据的双重支持下,预训练模型打开了深度学习模型规模与性能齐飞的局面,成为人工智能和深度学习领域的又一革命性突破,引发了国际著名互联网企业和研究机构的激烈竞争,将模型规模和性能不断推向新的高度。

目前,大规模预训练模型已经在自然语言处理领域取得了巨大的成功。BERT、GPT-3等大规模预训练模型被看做是“暴力美学”的一次胜利,验证了“模型越大,性能越好”的逻辑,业界也普遍形成了一种炼大模型的竞赛趋势,国内也相继发布了ERNIE、盘古、悟道等大规模预训练模型,呈现百花齐放、百家争鸣的发展格局。

然而在这样的成功背后,是海量的数据需求与训练资源消耗。以GPT-3为例,GPT-3有1750亿个参数,预训练数据量高达45TB,在超大算力资源的加持下,GPT-3训练一次的费用是460万美元,训练时间为355个GPU年,这是一般的实验室难以承担的。

研究发现,虽然大规模预训练模型在自然语言生成等领域的能力已接近人类,但大规模预训练模型对语言的理解有限,只是一个“更大的黑盒子”,依然存在“缺乏常识”的缺陷。此外预训练模型的迁移能力仍待研究,另一方面,大规模预训练模型的落地场景一直是个很大的挑战,学术界与产业界对大规模预训练模型的关注点也有着很大的差异。

大规模预训练模型上述优势和不足,将 AI 研究者推到了一个十字路口:大规模预训练模型是否能成功从自然语言扩展到其他领域?又会带来哪些新的挑战?大规模预训练语言模型能否实现认知智能?业界的大模型竞赛现象反映了什么问题?业界进展是怎样的,产业应用所面临的主要难点是什么?

围绕着这个研究及产业的热点领域,深圳市人工智能与机器人研究院牵头,联合深圳市人工智能学会发起这次论坛。邀请北大、粤港澳大湾区数字经济研究院等领域著名学者及华为、腾讯、平安、百度等产业专家进行深度解析,探讨大型预训练模型当前现状及未来发展方向,提升大模型在产业的技术和应用。本论坛包括主旨演讲及Panel研讨环节,站在行业视角探讨大模型的技术背景、发展趋势,及在医疗、金融等多个领域的应用探讨。

该论坛由深圳市人工智能与机器人研究院首席科学家李世鹏担任主席(做主题报告),北京大学教授/深圳市人工智能学会秘书长邹月娴担任共同主席。

届时,华为云人工智能领域首席科学家田奇、百度杰出架构师、百度文心(ERNIE)语义理解技术与平台负责人孙宇,腾讯天衍实验室主任郑冶枫、平安科技前沿技术部负责人王磊、粤港澳大湾区数字经济研究院认知计算与自然语言讲席科学家张家兴等产学专家将发表主题报告,深入解读当前大规模预训练模型的产业发展趋势。

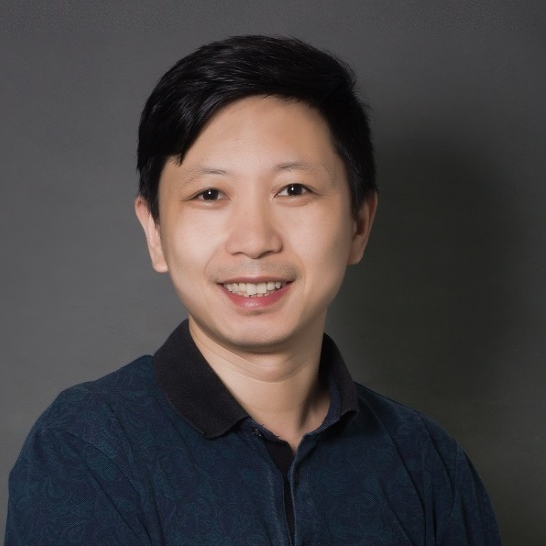

在论坛开始之前,AI科技评论采访了论坛主席、深圳市人工智能与机器人研究院首席科学家李世鹏,就大规模预训练的进展及本次论坛的准备情况进行了对话。

李世鹏是国际欧亚科学院院士和国际电机电子工程师学会会士(IEEE Fellow)。他于1999年作为创始成员加入微软亚洲研究院,曾担任副院长、首席研究员及多媒体计算组主任研究员。2018年加入科大讯飞,曾任集团副总裁及研究院联合院长。李院士研究方向为多媒体、互联网、计算机视觉等。曾任《IEEE电路与系统视频技术学报》总编辑,在多媒体、物联网及人工智能等领域极具影响力,拥有200多项美国专利并发表了330多篇国际论文(H指数:82),培养出四位MIT TR35创新奖的获得者。

Q:本届CNCC大会,除了您主持的“产业共话:大规模预训练的商业应用及技术发展方向”外,另外还有一个从学术角度讨论的“大规模预训练模型”论坛。学术界和产业界对大规模预训练模型的关注点有什么不一样?

A:大规模预训练模型自从GPT-3出来以后引起了包括学术界和工业界的很多反响。但大规模预训练是特别耗资源的一件事,现在国内能看到的大概只有ERNIE、盘古、悟道等几套,需要很大的财力和资源才能支持做这个事情,学术界基本做不了这事,基本上是跟着工业界合作,或者在别人的基础上做一些工作。

那么工业界为什么做这个事情呢?工业界做这个事情还是要看大规模预训练会对他们的商业目的带来什么好处。有些人说过,大规模预训练模型可能也是通往通用人工智能之路,现在大概是有那点苗子,但还远远没到那个程度。所以我们这个论坛也是让大家再讨论一下,到底这些大规模预训练模型今天有什么应用?预训练带来的好处在哪?它的限制在哪里?怎么去突破?通过这个论坛让大家进行碰撞,找到未来关注的一些点。

Q:目前深圳市人工智能与机器人研究院在大规模预训练模型的研究进展如何?

A:我们现在主要是在跟一些企业合作,这东西还是比较耗费资源。

我们论坛的嘉宾中有一位宋彦教授,他在我们研究院有一个自然语言处理大规模预训练模型的项目,我们会结合产业的一些需求进行研究,毕竟产业界更注重具体的落地应用。他们会有很多实际的需求,比如说信息挖掘、信息搜索或者是一些客服问答。在得到这些需求后,我们主要考虑如何通过这种大规模预训练模型,结合语言、知识、理解能力等,把这些商业应用的东西做得更好。

A:本次议程设计主要还是集中在业界关注的话题,以及大模型未来发展趋势的一些思考。我们想说的是现在的大模型其实是已经有一些基本的知识基础,那么接下来还有什么,如何引导其学习和归纳,“学而知之”,建立认知能力等等,如何去设想,如何去突破,我们的选择主题里面会考虑这方面的一些内容。

像邹月娴老师会说大模型在视觉推理里面的一个突破,百度的孙宇也会介绍基于认知的一个问答系统,华为的田奇老师也是带来了基于大模型的通用智能的一些探索。还有我们的粤港澳大湾区数字经济研究院的张家新老师,他的演讲主题也是从大模型走向认知科学。

所以说我们也在想现在的这个大模型之后的下一步,看看能不能引起一些这样的思考。比如现在的大模型不是所有人都能用得起的,下一步能否化繁为简赋能多数人?基于规则的模型通常意义上比基于数据的模型更简洁和稳定。我相信下一步不管是科研学术界以及业界可能都想对这个问题去了解及探讨。

我们这个论坛之所以叫做“产业共话”,就是希望探讨大家在实践中遇到的实际问题,而不是一味夸大大模型,我们想了解企业遇到过的瓶颈或者困难,这才是真正的有用的、有价值的东西,可以对我们后续的研究者有着启示。也能对大家共同去攻克这样的一些难题起到一个积极的作用。

Q:您提到大规模预训练模型可能是通向通用人工智能的道路,在您看来,人的认知过程对大规模训练模型研究有什么启发?

A:我们的思路是跟人的认知过程做一个对比。那人的认知过程是什么样子?我们现在机器又是什么样子?比如说我觉得大规模预训练模型对应的人的认知过程,可能就是一堆知识堆放在脑子里,死记硬背也许也会有点用。但是人真正的认知能力是可以举一反三,是有推理能力,是可以从未经历的事件中,推演出可能的结果。现在大规模预训练模型也许也可以举一反三,但是还是要需要人通过示例来引导才知道要做什么事。

人有些东西是生而知之的,生下来就有一些先验知识,那怎么通过这些知识进行推理?这就需要学而知之。人在学习的过程中不但学的是知识,而且还学习规则以及推理的能力。现在大规模预训练模型有一些往这个方向走的趋势,但还没有一个明确的路径。

所以我们现在也Push大家往这块去想,你有这样一个大规模预训练的模型,怎么更好去利用起来,或者有一些什么样的方法能让我们更好的去把它利用起来。就像我脑袋里灌了一堆知识,但是我不知道怎么去用它。如果能把人的认知过程,也就是人的学习的过程放进来,也许就会有一些新的发现。

比如说基于规则,我们在用大规模预训练模型的时候,它是需要你先给很多Example,从观察你的Example里面猜出来,你大概要想做这个事情。那么我们可以不可以把这个事情变得更显式,直接告诉它我的规则是什么?我们现在说Big Data,如果能从数据中找到规律,或者如果规则也像数据那么丰富且容易得到的话,我们就可以从Big Data到Big Rule,这可能就是向通用人工智能又接近了一步。

“大规模预训练模型的商业应用及技术发展方向”论坛日程安排

CNCC2021“产业共话:大规模预训练的商业应用及技术发展方向”技术论坛将于2021年10月28日16:00-19:00在深圳国际会展中心召开。齐聚华为、腾讯、百度、平安等行业龙头的大模型设计领军人物,联合科研机构专家共同探讨大型预训练模型产业化应用及新的发展方向。聚焦医疗和金融热门领域,把脉大模型技术发展方向。

本次论坛由深圳市人工智能于机器人研究院首席科学家李世鹏担任论坛主席。李世鹏是国际欧亚科学院院士和国际电机电子工程师学会会士(IEEE Fellow)。他于1999年作为创始成员加入微软亚洲研究院,曾担任副院长、首席研究员及多媒体计算组主任研究员。2018年加入科大讯飞,曾任集团副总裁及研究院联合院长。李院士研究方向为多媒体、互联网、计算机视觉等。曾任《IEEE电路与系统视频技术学报》总编辑,在多媒体、物联网及人工智能等领域极具影响力,拥有200+项美国专利并发表了330多篇国际论文(H指数:82),培养出四位MIT TR35创新奖的获得者。本次论坛李世鹏将发表《连接认知科学与认知智能:新人工智能发展之路?》的主题演讲。

北京大学教授、深圳市人工智能学会秘书长邹月娴担任论坛联合主席。邹月娴是北京大学深圳研究生院党委副书记,教授、博士生导师,ADSP实验室主任,CCF语音对话与听觉专委会委员。长期从事机器学习与模式识别、信号与信息处理领域科研与教学工作,先后主持国家级、地方级科研项目30多项,形成了一系列创新成果;曾获中国电子工业部科技进步三等奖,深圳市科学技术奖科技进步一等奖;在领域著名期刊(TIP、TSP等)和国际旗舰学术会议(NIPS、ACL、 AAAI 、CVPR等)上发表学术论文226篇,参与撰写中英文专著2本,授权发明专利10项。目前致力于跨媒体分析与理解、人机对话、深度学习理论方法与应用研究

(https://web.pkusz.edu.cn/adsp/)。

时间

| 主题

| 主讲

嘉宾

| 单位及任职

|

16:00-16:10

| 连接认知科学与认知智能:新人工智能发展之路?

| 李世鹏

| 深圳市人工智能与机器人研究院 首席科学家

|

16:10-16:30

| 预训练模型在视觉理解上的应用与发展

| 邹月娴

| 北京大学教授/深圳市人工智能学会秘书长

|

16:30-16:55

| 通用AI的探索和实践

| 田奇

| 华为云人工智能领域首席科学家

|

16:55-17:20

| 百度文心ERNIE预训练技术与平台

| 孙宇

| 百度杰出架构师、百度文心(ERNIE)语义理解技术与平台负责人

|

17:20-17:45

| 预训练模型在医学影像分析上的应用

| 郑冶枫

| 腾讯天衍实验室主任

|

17:45-18:10

| 大规模预训练模型在金融领域应用中面临的主要问题与应对技术探索

| 王磊

| 平安科技前沿技术部负责人

|

18:10-18:35

| 大模型时代的认知机器学习

| 张家兴

| 粤港澳大湾区数字经济研究院,认知计算与自然语言讲席科学家

|

18:35-19:05

| 圆桌论坛:

医疗大模型的应用及前景圆桌讨论

| 郑冶枫

陈杰

何径舟

宋彦

陈小军

张彤

| 腾讯

北京大学教授

百度NLP技术总监

香港中文大学(深圳)副教授

深圳大学 副教授

鹏城实验室 助理研究员

|

主题报告1:连接认知科学与认知智能:新人工智能发展之路?

人工智能发展迅猛,各种新技术日新月异,同时也出现一些瓶颈。让我们暂停一下步伐,看看认知科学的发展,对认知智能的发展有没有启示?认知科学的很多发现,可以在认知智能的研究中起到指导作用,以大规模的模型,以及大规模在人的认知过程中采集的真实数据,也许可以更准确地模拟人的认知过程。“像婴儿一样开始,像孩子一样学习”,也许是一条可行的新人工智能发展之路?大规模预训练模型可能仅仅是一个新的时代的开始。

主题报告2:预训练模型在视觉理解上的应用与发展

视觉理解是计算机视觉领域的前沿研究热点,涉及视觉场景的感知与认知,涵盖图像分类、目标检测、行为识别、时序动作定位(TAL)等单模态任务,也包括视觉描述(VC)和语言查询视频定位(VG)等跨模态任务。随着深度学习的快速发展,基于大规模标注数据的视觉预训练模型、视觉-语言预训练模型、语言预训练模型助力多个下游任务取得了SOTA的性能。然而现有预训练任务通常与下游任务存在较大的语义鸿沟,并非在所有下游任务上可以获得性能增益。本次讲座将首先介绍视觉理解任务研究现状,预训练模型方法演进及其在视觉理解任务上的应用,最后分享细粒度跨模态预训练方法及其在视觉定位上的最新研究成果。

主题报告3:通用AI的探索和实践

随着数据的不断积累和算力算法的不断发展,人工智能模型正在变的更大更通用。为了实现普惠AI,华为云在2021年HDC大会发布了盘古预训练大模型,建立了一套通用、易用的人工智能工业化开发模式。在该报告中,将从数据高效、模型高效、知识高效三个方面深入介绍华为云盘古大模型,尤其是华为云视觉大模型背后的预训练技术。

主题报告4:预训练模型在医学影像分析上的应用

由于隐私和监管问题,医学影像的获得特别困难。同时医学影像的标注经常需要医学专业知识,只有专家才能准确标注。这些都导致有标注的医学影像数据极其稀少。预训练是解决标注样本稀缺的有效手段,然而由于自然图像与医学影像的差异,在自然图像上预训练好的模型迁移到医学影像上效果往往参差不齐。同时很多医学成像模态是3维的(比如CT和核磁共振成像),业界更加缺乏预训练好的3维影像分析模型。本次讲座将介绍我们近期在医学影像预训练上的一些工作,比如,Med3D项目采取积少成多的方法,将业界的多个公开3维医学影像数据聚拢起来,联合预训练一个多模态、多器官的模型;我们也提出魔方变换的自监督学习算法,预训练时只需要3维医学影像而不需要任何标签;最后将介绍一种基于对比学习和Transformer架构的预训练方法。

主题报告5:百度文心ERNIE预训练技术与平台

近年来,预训练语言模型在自然语言处理领域发展迅速,并获得广泛应用。2019年,百度率先提出了基于知识增强预训练技术ERNIE,取得世界级突破。2020年,ERNIE又在语言生成、跨模态理解、多语言理解等方向取得突破,先后提出了ERNIE-GEN、ERNIE-VIL、ERNIE-M等模型,取得几十项SOTA,登顶十余项世界权威评测榜首。2021年,百度发布知识增强大模型ERNIE3.0,刷新50余个中文NLP基准,并登顶SuperGLUE榜首。ERNIE广泛应用于搜索引擎、金融风控、智能客服等产品,覆盖金融、通信、教育、互联网等行业。本次报告主要包含百度文心ERNIE预训练技术的最新进展、应用情况以及未来发展方向。

主题报告6:大规模预训练模型在金融领域应用中面临的主要问题与应对技术探索

大规模预训练模型在最近几年获得了蓬勃发展,其在各行各业的应用也逐渐普遍起来。在金融领域应用这些大规模预训练模型解决场景问题给我们带来了很多便利,但也面临一些问题。其中两个问题尤其值得关注:一是大规模预训练模型基于大语料训练,其在解决金融领域问题时不可避免的会引入过多背景信息,这些信息的存在可能在我们建立领域文本认知模型时引入了噪音;二是基于大规模预训练模型建立的各类NLP模型,其性能确有提升,但金融领域天然容错性低,目前不少模型的结果需要人工核对后才可使用,这阻碍了实际的商业应用。如何解决这些问题是值得思考的,为抛砖引玉,针对上述两个问题我们将分别介绍语义空间分解及置信度评估两类技术探索。

主题报告7:大模型时代的认知机器学习

让机器像人一样去学习,是机器学习领域一直在追求的目标。当下,大规模预训练模型展现出了在零样本和小样本学习、样本生成、先天支持后天等方面的强大潜力,而这些正是通往类人的认知机器学习道路上的重要基石。本次演讲,将和大家一起探讨大模型时代认知机器学习的实践之路。

圆桌论坛:医疗大模型的应用及前景圆桌讨论

嘉宾:

郑冶枫,腾讯天衍实验室

陈杰,北京大学

宋彦,香港中文大学(深圳)

何径舟,百度

陈小军,深圳大学

张彤,鹏城实验室

北京大学副教授,围绕计算机视觉和医学图像分析展开研究,发表期刊和会议论文约100余篇,代表论文包括国际顶级刊物TPAMI,IJCV,TSMC,TIP,TNNLS以及国际顶级会议CVPR,ICCV,NeurIPS等。Google Scholar 引用4700余次,单篇文章的最高引用达到了1100次,次高引用900余次。近五年先后获国家自然科学基金项目3项,主持广东重点项目1项,广东应急项目1项,作为课题负责人主持工信部5G+医疗健康应用试点项目。获国家科技进步二等奖两次(2005,2015)。担任国际顶级期刊TPAMI和IJCV的客座编辑、TVCJ的编委、国际顶级会议的研讨会共同主席,例如(ICCV,CVPR,ECCV和ACM MM)。

宋彦教授现为香港中文大学(深圳) 副教授。宋教授的研究方向包括自然语言处理、信息检索和抽取、文本表征学习等。其著作多次被国际权威组织或会议收录,如国际计算语言学协会(ACL),美国人工智能协会(AAAI),自然语言处理的经验方法会议(EMNLP),国际人工智能联合会议(IJCAI)等等。

除学术论文著作颇丰外,宋教授还拥有丰富的实践经历。他于2010年在微软亚洲研究院担任访问研究员,参与构建了第一个大规模中文组合范畴语法树库和语法分析器;于2011至2012年担任华盛顿大学访问学者;后于2013至2017年加入微软人工智能研究中心,成为“微软小冰”项目的创始人之一;在2017到2019年间,他加入腾讯人工智能实验室,作为自然语言理解(NLU)团队首席研究员,领导构建了腾讯AI Lab大规模中文词向量数据集(包括800万中文词),该数据集成为2018年十大人工智能开源数据集。目前,宋教授正作为研究科学家,于深圳市大数据研究院进行医疗文本表征学习研究。

何径舟,百度深圳研发中心自然语言处理部技术总监,螺旋桨 PaddleHelix 生物计算平台负责人。何径舟毕业于北京大学计算机系,有 10 年以上人工智能技术研发和管理经验,主要研究领域包括自然语言处理、机器学习、生物计算、智能机器人等。何径舟深度参与了知识增强的语义理解技术与平台文心ERNIE、大规模隐变量对话模型 PLATO 、飞桨图学习框架 PGL 、飞桨强化学习框架 PARL 、生物计算平台螺旋桨 PaddleHelix 、小度机器人等代表性工作,带领团队夺得十余项国际比赛和权威榜单冠军,4 次斩获百度最高奖。何径舟是 200 余项 AI 专利发明人,曾获中国专利优秀奖,受聘中国专利审查技术专家。何径舟也是中国人工智能学会(CAAI)会员,香港人工智能与机器人学会(HKSAIR)会员,中文信息学会(CIPS)青年工作委员会委员。

陈小军,深圳大学计算机与软件学院副教授,大数据技术与应用研究所助理所长,CCF YOCSEF深圳AC委员,2020年度主席。曾参与过多项国家863项目以及中国科学院战略性先导科技专项。领导开发开源数据挖掘平台AlphaMiner v1.1-v2.5版本,在国内外多所学校做教学软件使用。2010年开始,领导开发AlphaMiner云计算版本,并在2010及2011年深圳中国国际高新技术成果交易会予以展示。曾参与中科院战略先导专项开发了基于互联网的云计算大数据挖掘平台。从事数据挖掘、机器学习研究十余年,在相关的国际学术期刊和会议上发表SCI/EI检索论文近50篇,包括CCF A 类/一区论文20余篇(发表在KDD、ICCV、IJCAI、AAAI、SIGIR、TKDE,TNNLS上),CCF B/C类论文十余篇。主要研究内容涉及聚类算法、特征选择算法、有监督及半监督学习算法、基因数据聚类分析及图像分析等。

张彤,鹏城实验室助理研究员,CCF女工委委员,CCF YOCSEF深圳AC委员,深圳市女科技工作者协会副会长,深圳市海外高层次人才,国家优秀自费留学生奖学金获得者,博士毕业于澳大利亚悉尼大学,2015-2019在英国伦敦大学国王学院从事博士后研究工作。主要研究方向为多模态多维度医学影像分析,受邀担任多个顶级期刊及会议的审稿人,多次受邀在国内外学术会议上给主题/邀请报告,谷歌学术引用1300余次。

CNCC2021将于10月28-30日在深圳举行,今年大会主题是“计算赋能加速数字化转型”。CNCC是计算领域学术界、产业界、教育界的年度盛会,宏观探讨技术发展趋势,今年预计参会人数将达到万人。每年特邀报告的座上嘉宾汇聚了院士、图灵奖得主、国内外名校学者、名企领军人物、各领域极具影响力的业内专家,豪华的嘉宾阵容凸显着CNCC的顶级行业水准及业内影响力。

今年的特邀嘉宾包括ACM图灵奖获得者John Hopcroft教授和Barbara Liskov教授,南加州大学计算机科学系和空间研究所Yolanda Gil教授,陈维江、冯登国、郭光灿、孙凝晖、王怀民等多位院士,及众多深具业内影响力的专家。今年的技术论坛多达111个,无论从数量、质量还是覆盖,都开创了历史之最,将为参会者带来学术、技术、产业、教育、科普等方面的全方位体验。大会期间还将首次举办“会员之夜”大型主题狂欢活动,让参会者畅快交流。

CNCC2021将汇聚国内外顶级专业力量、专家资源,为逾万名参会者呈上一场精彩宏大的专业盛宴。别缺席,等你来,欢迎参会报名!

CNCC2021参会报名

返回首页

返回首页