ADL116《大规模预训练模型》开始报名

CCF学科前沿讲习班

The CCF Advanced Disciplines Lectures

CCFADL第116期

主题 大规模预训练模型

2021年5月23-25日 北京

本期CCF学科前沿讲习班《大规模预训练模型》,对大规模预训练技术最新研究进展及在视觉、语音、语言等多种模态下的预训练进行系统性介绍,帮助学员理解预训练的基本概念、主要挑战和解决方法,掌握该领域包括视觉预训练、语音预训练、语言预训练以及多模态预训练的一系列前沿技术,并通过实际案例了解预训练的应用前景,开阔科研视野,增强实践能力。

本期ADL讲习班邀请到了本领域10位来自于著名高校与企业科研机构的重量级专家学者做主题报告。他们将对大规模预训练模型在语言、视觉、语音和多模态方面的最新进展进行深入浅出的讲解,为听众展示在自然语言理解、计算机视觉以及语音语义等领域的实践案例, 并介绍如何解决并行训练效率的挑战,如何压缩、加速和部署大模型等解决人工智能落地问题的宝贵经验。

学术主任:宋睿华 中国人民大学

主办单位:中国计算机学会

活动日程:

2021年5月23日(周日) | |

9:00-9:15 | 开班仪式 |

9:15-9:30 | 全体合影 |

9:30-11:30 | 专题讲座1:Transformer综述 邱锡鹏,复旦大学计算机学院教授 |

11:30-13:00 | 午餐 |

13:00-15:00 | 专题讲座2:大规模视觉表征学习 翟晓华 瑞士苏黎世谷歌大脑团队 Staff Researcher |

15:00-15:15 | 休息 |

15:15-17:15 | 专题讲座3:预训练模型加速研究和实践 尚利峰,华为诺亚方舟实验室语音语义团队研究员 |

2021年5月24日(周一) | |

9:00-10:00 | 专题讲座4:自督导式学习在自然语言处理上的观察以及在语音处理上的应用 李宏毅 台湾大学电机工程学系副教授(台湾大学资讯工程学系合聘) |

10:00-10:15 | 休息 |

10:15-11:45 | 专题讲座5:预训练的应用场景之多模态理解与表达 宋睿华 中国人民大学高瓴人工智能学院长聘副教授 |

11:45-13:45 | 午餐 |

13:45-17:00 | 专题讲座6:State-of-the-Arts, Benchmarks and Future of Pre-trained Models for Multilingual, Multimodal, Code and Generation 段楠 (Principal Research Manager at Microsoft Research Asia)&宫叶云 (Senior Researcher at Microsoft Research Asia) |

2021年5月25日(周二) | |

9:00-11:00 | 专题讲座7:大规模中文多模态预训练模型 卢志武 中国人民大学高瓴人工智能学院教授 |

11:30-13:00 | 午餐 |

13:00-15:00 | 专题讲座8:知识指导的预训练语言模型 刘知远 清华大学计算机系副教授 |

15:00-15:15 | 休息 |

15:15-17:15 | 专题讲座9:大规模预训练模型对AI系统的挑战和解决之道 袁进辉 北京一流科技有限公司创始人 |

17:15-17:30 | 小结 |

特邀讲者:

邱锡鹏,复旦大学计算机学院教授

讲者简介:邱锡鹏,复旦大学计算机学院教授,国家优青获得者,于复旦大学获得理学学士和博士学位。主要从事自然语言处理、深度学习等方向的研究,发表CCF A/B类论文70余篇,获得ACL 2017杰出论文奖(CCF A类)、CCL 2019最佳论文奖,有4篇论文入选PaperDigest发布的IJCAI/ACL/EMNLP的最有影响力论文(各会议每年10篇)。出版开源专著《神经网络与深度学习》,Github关注数1.4万,豆瓣评分9.4分。主持开发了开源框架FudanNLP和FastNLP,已被国内外数百家单位使用。2015年入选首届中国科协青年人才托举工程项目,2018年获钱伟长中文信息处理科学技术奖青年创新奖一等奖,2020-2021年连续两年入选由清华-中国工程院知识智能联合研究中心发布的"AI 2000人工智能全球最具影响力提名学者"等。培养学生曾获中国中文信息学会优博、中国人工智能学会优博、上海市优博、微软学者、百度奖学金等。

报告题目:Transformer综述

报告摘要:目前Transformer在自然语言处理、计算机视觉领域取得了广泛的成功。本报告主要介绍Transformer模型的基础自注意力机制以及变体。主要涵盖两部分内容:1)Transformer及其改进模型:通过分析Transformer的基本原理和优缺点,提出一些改进模型Star-Transformer、Multi-Scale Transformer、BP-Transformer等。2)Transformer模型的应用:将Transformer模型应用在文本分类、实体名识别、图像分类等任务上,并通过针对性的改进来进一步提高性能。最后,对Transformer模型及其未来发展趋势进行展望。

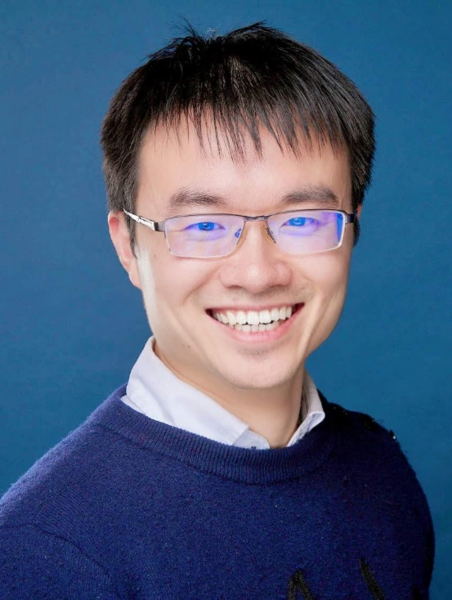

翟晓华 瑞士苏黎世谷歌大脑团队 Staff Researcher

讲者简介:翟晓华,现任瑞士苏黎世谷歌大脑团队Staff Researcher,研究方向为表征学习、深度学习、人工智能。他于2014年在北京大学获得博士学位。他负责的大规模迁移学习算法“Big Transfer (BiT)”基于亿级规模图像数据来预训练模型,在超过二十个视觉任务上取得良好的效果;作为共同一作,他提出的“Vision Transformer (ViT)”将Transformer模型应用于图像识别,取得了与计算机视觉领域的主流模型CNN相当的效果。这两个特征学习项目及模型已开源,在GitHub上共获得超过3000个星标。他是“Compare GANs”项目的主要贡献者,在Github上获得1700个星标。他发表了包括ICLR、ICML、CVPR、ICCV、ECCV在内的多篇国际顶级会议和期刊论文。2012年作为彭宇新教授团队的核心成员参加由美国国家标准技术局举办的TRECVID中的INS比赛,并获得国际第一名。他是IEEE TPAMI、TIP、TMM、ICLR、ICML、CVPR、ECCV、ICCV和NeurIPS等国际顶级期刊和会议的审稿人。

报告题目:大规模视觉表征学习

报告摘要:计算机视觉模型一般需要大量训练样本来识别新的物体,样本标注限制了计算机视觉模型的落地应用。本报告介绍如何通过大规模视觉模型预训练,及小样本条件下的迁移学习,来解决上述问题。本报告首先介绍基于亿级规模图像数据预训练的“Big Transfer (BiT)”模型和“Vision Transformer (ViT)”模型,然后介绍如何将上述模型应用于小样本、多样化的视觉任务"Visual Task Adaptation Benchmark (VTAB)"。最后,本报告将探讨广泛使用的“ImageNet”分类任务,并且分析多个state-of-the-art计算机视觉模型的性能。

尚利峰,华为诺亚方舟实验室语音语义团队研究员

讲者简介:尚利峰,华为诺亚方舟实验室语音语义团队研究员,香港大学计算机专业博士。当前主要从事预训练模型加速、知识表示和推理、对话系统等方向的研究。在人工智能相关顶尖会议,如ICLR、NeurIPS、ACL、EMNLP 、CVPR、KDD和AAAI 等,发表多篇论文,包括ACL五年高引论文(前0.5%)、EMNLP-2020最有影响力论文、CGI-2014最佳论文奖、ACL-2019最佳论文提名。研究工作被广泛用在公司终端产品和云侧服务,获公司最高个人和团队奖。

报告题目:预训练模型加速研究和实践

报告摘要:最近OpenAI和华为分别发布了英文和中文的千亿级大模型,大模型在不断地刷新各个榜单,但是预训练模型的端云部署也变得更加棘手。如何将大模型在对话、搜索等产品形成生产力,体现它的商业价值,是我们不得不面对和解决的难题。本报告主要介绍业界和诺亚语音语义团队在预训练模型加速方向上的研究和商业化探索。在模型压缩方面,主要介绍基于蒸馏、量化、剪枝等压缩技术,以及多种技术融合的大模型压缩。在预训练模型实践方面,主要介绍大模型在对话和搜索场景的加速和部署。

李宏毅 台湾大学电机工程学系副教授(台湾大学资讯工程学系合聘)

讲者简介:李宏毅分别在 2010 年和 2012 年于台湾大学(National Taiwan University, NTU)取得硕士和博士学位;2012 年到 2013 年,他于中央研究院资讯科技创新研究中心担任博士后研究员;2013 年到 2014 年,他是麻省理工学院(MIT)电脑科学和人工智慧实验室(CSAIL)口语系统组的客座科学家。他目前是国立台湾大学电机工程学系副教授(台湾大学资讯工程学系合聘)。他的研究主轴是深度学习、语音处理及语意理解,他于 2017 年荣获中华民国电脑学会杰出青年奖,2018 年荣获电机工程学会优秀青年电机工程师奖,2019 年荣获杰出人才发展基金会年轻学者创新奖、中华民国科技部吴大猷先生纪念奖。

报告题目:自督导式学习在自然语言处理上的观察以及在语音处理上的应用

报告摘要:利用自监督式学习(Self-supervised learning)在大量的无人工标记(Unlabeled)资料上进行预训练(Pre-train)已经逐渐形成趋势,知名的BERT、GPT等模型都可说是自监督式学习模型。在本演讲中,我会先分享一些与BERT 相关的有趣发现,然后讲述怎麽把自督导式学习用在语音处理上。

段楠 (Principal Research Manager at Microsoft Research Asia)&宫叶云 (Senior Researcher at Microsoft Research Asia)

讲者简介:段楠博士,现任微软亚洲研究院高级研究经理,天津大学兼职教授,微软亚洲研究院-中国科学技术大学/中山大学/北京航空航天大学联合培养博士生导师,主要从事多语言多模态预训练、智能问答、代码智能和机器推理等研究,CCF高级会员,EMNLP/ADL Tutorial讲者,曾任NLPCC评测主席、ACL系列会议高级领域主席和领域主席,CCF-NLPCC青年科学家,发布XGLUE、CodeXGLUE、NLPCC-KBQA/DBQA等开源学术数据集,著有《智能问答》,发表学术论文100余篇,持有专利10余项,多项研究成果用于微软各类人工智能产品。

讲者简介:宫叶云,微软亚洲研究院主管研究员。研究兴趣包括自然语言生成,智能问答和长文本建模。在国际学术期刊和会议(ACL, EMNLP, IJCAI, AAAI, CIKM, COLING等)上发表论文30余篇。获批美国专利6项。他的项目Microsoft Quiz在微软黑客马拉松世界知识黑客中获得最佳技术黑客奖。他的工作PoolingFormer在NQ与TyDi QA榜上排名第一,同时KFC模型在CommonGen榜上排名第一。他所设计的模型先知网络被广泛应用在微软广告,必应搜索,和小冰中。

报告题目:State-of-the-Arts, Benchmarks and Future of Pre-trained Models for Multilingual, Multimodal, Code and Generation

报告摘要:In this talk, we will introduce several state-of-the-art (SOTA) pre-trained models with the current best performance on multilingual, multimodal, code and generation tasks, including (1) Unicoder for multilingual natural language understanding (NLU); (2) Unicoder-VL for image/video retrieval, captioning and question answering, and GODIVA for open-domain video generation from text; (3) CodeBERT for code retrieval and code generation; (4) ProphetNet and its variants for multilingual, knowledge-aware and efficient natural language generation (NLG). We will also introduce our latest benchmark efforts for diversified pre-trained model research, including XGLUE for multilingual NLU and NLG evaluation, GEM for multimodal evaluation with texts, images, and videos, CodeXGLUE for code-related evaluation, and GLGE for NLG evaluation. Last, we will share our thoughts on the future of pre-trained model research.

卢志武 中国人民大学高瓴人工智能学院教授

讲者简介:卢志武,中国人民大学高瓴人工智能学院教授,博士生导师。2005年7月毕业于北京大学数学科学学院信息科学系,获理学硕士学位;2011年3月毕业于香港城市大学计算机系,获PhD学位。主要研究方向包括机器学习、计算机视觉等。主持NSFC、KJW等多个国家项目。首个公开的中文通用图文预训练模型BriVL设计者。以主要作者身份发表学术论文70余篇,其中在TPAMI、IJCV、TIP等重要国际期刊和ICLR、NeurIPS、CVPR、ICCV、ECCV等重要国际会议上发表论文40余篇,CCF A类论文30篇,入选ESI高被引论文1篇。获深度学习权威评测ImageNet 2015视频检测任务亚军、2015年IBM SUR Award、计算机图形学国际会议CGI 2014最佳论文奖等。担任CCF生物信息学专委会委员。

报告题目:大规模中文多模态预训练模型

报告摘要:近年来,大规模多模态预训练成为人工智能领域研究热点。现有工作大多假设图文之间存在强语义相关,而这与现实世界并不相符,在预训练数据为网络爬取数据的情况下尤其如此。针对这一问题,我们从图文弱相关性的假设出发,提出了一种双塔结构的预训练模型-文澜。文澜的预训练核心算法为跨模态对比学习,并利用DeepSpeed进行加速。大量的实验结果证明了文澜的有效性,并且一些下游demo也展现了文澜的强大理解能力。

刘知远 清华大学计算机系副教授

讲者简介:刘知远,清华大学计算机系副教授、博士生导师。主要研究方向为表示学习、知识图谱和社会计算。已在ACL、IJCAI、AAAI等人工智能领域的著名国际期刊和会议发表相关论文80余篇,Google Scholar统计引用超过1.2万次。承担多项国家自然科学基金。曾获中文信息学会青年创新奖,入选国家万人计划青年拔尖人才、中国科学青年人才托举工程。

报告题目:知识指导的预训练语言模型

报告简介:近年来深度学习成为自然语言处理关键技术,特别是2018年以来的预训练语言模型显著提升了自然语言处理的整体性能。作为典型的数据驱动方法,以预训练语言模型为代表的深度学习仍然面临可解释性不强、鲁棒性差等难题,如何将人类积累的大量语言知识和世界知识引入模型,是改进深度学习性能的重要方向,同时也面临很多挑战。本报告将系统介绍知识指导的预训练语言模型的最新进展与趋势。

袁进辉 北京一流科技有限公司创始人

讲者简介:袁进辉,原微软亚洲研究院主管研究员,现北京一流科技有限公司创始人,致力于打造新一代深度学习框架OneFlow。兼任之江实验室天枢开源开放人工智能平台架构师,北京智源人工智能研究院大模型技术委员会委员,中关村数智人工智能产业联盟副理事长。2008年7月自清华大学计算机系获得工学博士学位,获得清华大学优秀博士学位论文奖,袁进辉曾于攻读博士期间在计算机视觉及多媒体领域顶级会议上发表多篇论文,并连续多年获得美国国家技术标准局组织的视频检索评测比赛的第一名。2013年加入微软亚洲研究院从事大规模机器学习平台的研发工作,于2014年发明了当时世界上最快的主题模型训练算法和系统LightLDA,只用数十台服务器即可完成以前数千台服务器才能实现的大规模主题模型,该技术成功应用于微软在线广告系统,2015年至2016年底,专注于搭建基于异构集群的深度学习平台,荣获微软亚洲研究院院长特别奖。

报告题目:大规模预训练模型对AI系统的挑战和解决之道

报告摘要:大规模预训练模型因其在文本生成等应用上优异的表现而备受关注,但开展此类研究壁垒极高:一方面,大规模预训练模型所依赖的硬件基础设施建设成本高昂,另一方面,此类大规模分布式训练面临“内存墙”的技术挑战,通用深度学习框架仅支持数据并行,还不能支持大规模预训练模型所需要的模型并行、流水并行等技术,只有高度定制的专用软件系统才能满足需求。本报告将梳理和总结大规模预训练模型时所面临的技术挑战和基本解决思路,深度解析已开源的主流解决方案Nvidia Megatron-LM和Microsoft DeepSpeed的技术原理和使用方法,以及基于OneFlow的大规模预训练模型解决方案的原理和使用方法。最后,报告也将对未来发展方向进行展望。

学术主任:宋睿华 中国人民大学高瓴人工智能学院长聘副教授

简介:宋睿华博士,中国人民大学高瓴人工智能学院长聘副教授,曾任微软亚洲研究院主管研究员和微软小冰首席科学家。她的算法完成了人类史上第一本人工智能创作的诗集《阳光失了玻璃窗》。宋睿华博士是具有国际影响力的人工智能科学家,发表学术论文80余篇,申请国际专利25项。她是SIGIR 2021短文的PC Chair,EMNLP 2021的Senior Area Chair,和Information Retrieval Journal的主编。近期的研究兴趣包括人工智能的文本创作、自然语言的多模态理解和多模态对话。

报告题目:预训练的应用场景之多模态理解与表达

报告摘要: 认知科学的体验革命带来人们对于从语言理解意义的新观点:思考以及使用语言的能力是我们的肉身与头脑合作的成果。肉身包括视觉、听觉、嗅觉、触觉和运动神经等各种各样的模态。人类的孩子是在多模态环境下学习语言,这也是目前AI欠缺的部分。讲座将从探讨人类如何将语言变成意义出发,介绍我们从语言到图像的多模态理解方面的工作,并提出多模态表达(例如表情、动作、灯光颜色和语音等)的问题,为大规模预训练提供新的应用场景和目标。

时间:2021年5月23-25日

地点:北京•中国科学院计算技术研究所一层报告厅(北京市海淀区中关村科学院南路6号)

报名须知:

1、报名费:CCF会员2800元,非会员3600元。食宿交通费用自理。根据交费先后顺序,会员优先的原则录取,额满为止。

2、报名截止日期:2021年5月23日。报名请预留不会拦截外部邮件的邮箱,如qq邮箱。

3、联系:李红梅 邮箱 : adl@ccf.org.cn

缴费方式:

在报名系统中在线缴费或者通过银行转账

银行转账(支持网银、支付宝):

开户行:招商银行北京海淀支行

户名:中国计算机学会

账号:110943026510701

请务必注明:姓名+ADL116

报名缴费后,报名系统中显示缴费完成,即为报名成功。

报名方式:请选择以下两种方式之一报名:

1、扫描(识别)以下二维码报名:

2、点击报名链接进行报名:https://conf.ccf.org.cn/ADL116

返回首页

返回首页